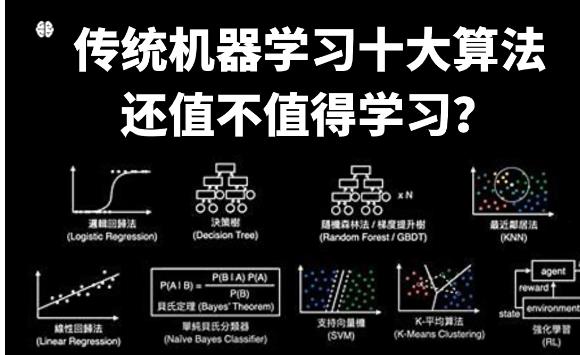

機(jī)器學(xué)習(xí)是一門涉及統(tǒng)計(jì)學(xué)、概率論和計(jì)算機(jī)科學(xué)等多個(gè)領(lǐng)域的交叉學(xué)科,旨在讓計(jì)算機(jī)系統(tǒng)通過數(shù)據(jù)學(xué)習(xí)并改進(jìn)自身性能。在機(jī)器學(xué)習(xí)中,算法扮演著至關(guān)重要的角色,它們決定了模型的性能和效果。下面介紹十大機(jī)器學(xué)習(xí)算法:

線性回歸(Linear Regression):線性回歸是最簡(jiǎn)單的機(jī)器學(xué)習(xí)算法之一,用于預(yù)測(cè)一個(gè)或多個(gè)連續(xù)變量的數(shù)值。它通過擬合一條直線或平面來描述特征與目標(biāo)變量之間的關(guān)系。

邏輯回歸(Logistic Regression):邏輯回歸用于解決分類問題,將輸入數(shù)據(jù)映射到一個(gè)0或1的輸出。邏輯回歸常用于二分類問題,但也可擴(kuò)展到多分類問題。

決策樹(Decision Tree):決策樹是一種基于樹狀結(jié)構(gòu)的分類器,通過一系列簡(jiǎn)單的決策規(guī)則來預(yù)測(cè)目標(biāo)變量。決策樹易于解釋和理解,適用于非線性問題。

支持向量機(jī)(Support Vector Machine, SVM):支持向量機(jī)是一種強(qiáng)大的監(jiān)督學(xué)習(xí)算法,用于解決分類和回歸問題。它通過找到最大間隔超平面來劃分?jǐn)?shù)據(jù)。

樸素貝葉斯(Naive Bayes):樸素貝葉斯是基于貝葉斯定理和特征條件獨(dú)立假設(shè)的分類算法。它適用于大規(guī)模數(shù)據(jù)集和高維特征空間。

K均值聚類(K-means Clustering):K均值聚類是一種無監(jiān)督學(xué)習(xí)算法,用于將數(shù)據(jù)分為K個(gè)簇。它通過最小化每個(gè)簇內(nèi)部的平方誤差和,來確定數(shù)據(jù)點(diǎn)的簇歸屬。

隨機(jī)森林(Random Forest):隨機(jī)森林是一種集成學(xué)習(xí)算法,通過多個(gè)決策樹的投票來進(jìn)行分類或回歸。隨機(jī)森林能夠降低過擬合風(fēng)險(xiǎn),提高模型的泛化能力。

神經(jīng)網(wǎng)絡(luò)(Neural Network):神經(jīng)網(wǎng)絡(luò)是一種模擬人腦神經(jīng)元連接方式的深度學(xué)習(xí)算法,用于解決復(fù)雜的非線性問題。深度神經(jīng)網(wǎng)絡(luò)在圖像識(shí)別、語音識(shí)別等領(lǐng)域取得了顯著成果。

支持向量回歸(Support Vector Regression, SVR):支持向量回歸是一種回歸算法,用于處理連續(xù)性的變量。與SVM類似,SVR也通過找到最大間隔超平面來進(jìn)行回歸分析。

集成學(xué)習(xí)(Ensemble Learning):集成學(xué)習(xí)是一種結(jié)合多個(gè)基本模型來提升整體性能的方法。常見的集成學(xué)習(xí)方法包括Bagging、Boosting和Stacking等。

以上是機(jī)器學(xué)習(xí)中的十大經(jīng)典算法,它們?cè)诓煌I(lǐng)域和問題中都有各自的優(yōu)勢(shì)和適用性。在實(shí)際應(yīng)用中,選擇合適的算法和調(diào)優(yōu)模型參數(shù)是提高機(jī)器學(xué)習(xí)效果的關(guān)鍵。隨著機(jī)器學(xué)習(xí)領(lǐng)域的不斷發(fā)展,還會(huì)涌現(xiàn)出更多新的算法和技術(shù),為我們帶來更多機(jī)遇和挑戰(zhàn)。