- Introduction - Probabilistic and Statistical Machine Learning 2020

- Lecture 1 - Introduction

- Lecture 2 - Reasoning under Uncertainty

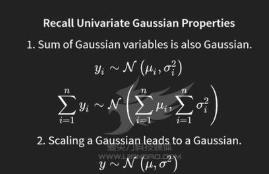

- Lecture 3 - Continuous Variables

- Lecture 4 - Sampling

- Lecture 5 - Markov Chain Monte Carlo

- Lecture 6 - Gaussian Distributions

- Lecture 7 - Gaussian Parametric Regression

- Lecture 8 - Learning Representations

- Lecture 9 - Gaussian Processes

- Lecture 10 - Understanding Kernels

- Lecture 11 - Example of GP Regression

- Lecture 12 - Gauss-Markov Models

- Lecture 13 - Gaussian Process Classification

- Lecture 14 - Generalized Linear Models

- Lecture 15 - Exponential Families

- Lecture 16 - Gaussian Process Classification

- Lecture 17 - Factor Graphs

- Lecture 18 - The Sum-Product Algorithm

- Lecture 19 — Extended Example- Topic Modelling

- Lecture 20 — Latent Dirichlet Allocation

- Lecture 21 — Expectation Maximization (EM)

- Lecture 22 — Variational Inference

- Lecture 23 — Tuning Inference Algorithms

- Lecture 24 — Customizing Probabilistic Models

- Lecture 25 — Making Decisions

- Lecture 26 — Revision

概率推理系統(tǒng)地應(yīng)用于所有的推理問題,包括統(tǒng)計模型的推理參數(shù),有時被稱為貝葉斯方法。然而,這個詞往往會引起非常強(qiáng)烈的反應(yīng)(積極或消極,取決于你問誰),所以我們更喜歡中性的術(shù)語“概率方法”。此外,我們將經(jīng)常使用最大似然估計等技術(shù),它們不是貝葉斯方法,但肯定屬于概率范式。

一、EM算法的基礎(chǔ)和貝葉斯基礎(chǔ)

1)EM算法的基本原理和推導(dǎo)

2)EM算法的基本應(yīng)用,k-means和高斯混合模型

二、隱馬可夫和條件隨機(jī)場

1)隱馬(HMM)的基于原理和對應(yīng)的三個問題及其解法

2)最大熵模型

3)條件隨機(jī)場

三、話題模型

話題

四、其它

1)采樣

2)變化

3) 卡爾曼濾波器

4) 粒子濾波

5)非參數(shù)貝葉斯