- 1. 2-1 機器學(xué)習(xí)、深度學(xué)習(xí)簡介

- 2. 2-2 神經(jīng)元-邏輯斯底回歸模型

- 3. 2-3 神經(jīng)元多輸出

- 4. 2-4 梯度下降

- 5. 2-5 數(shù)據(jù)處理與模型圖構(gòu)建(1)

- 6. 2-6 數(shù)據(jù)處理與模型圖構(gòu)建(2)

- 7. 2-8 神經(jīng)網(wǎng)絡(luò)實現(xiàn)(多分類邏輯斯蒂回歸模型實現(xiàn))

- 8. 3-1 神經(jīng)網(wǎng)絡(luò)進階

- 9. 3-2 卷積神經(jīng)網(wǎng)絡(luò)(1)

- 10. 3-3 卷積神經(jīng)網(wǎng)絡(luò)(2)

- 11. 3-4 卷積神經(jīng)網(wǎng)絡(luò)實戰(zhàn)

- 12. 4-1 卷積神經(jīng)網(wǎng)絡(luò)進階(alexnet)

- 13. 4-2 卷積神經(jīng)網(wǎng)絡(luò)進階(Vggnet-Resnet)

- 14. 4-3 卷積神經(jīng)網(wǎng)絡(luò)進階(inception-mobile-net)

- 15. 4-4 VGG-ResNet實戰(zhàn)(1)

- 16. 4-5 VGG-ResNet實戰(zhàn)(2)

- 17. 4-6 Inception-mobile_net(1)

- 18. 4-7 Inception-mobile_net(2)

- 19. 5-1 adagrad_adam

- 20. 5-2 激活函數(shù)到調(diào)參技巧(1)

- 21. 5-3 激活函數(shù)到調(diào)參技巧(2)

- 22. 5-4 Tensorboard實戰(zhàn)(1) (1)

- 23. 5-6 fine-tune-實戰(zhàn)

- 24. 5-7 activation-initializer-optimizer-實戰(zhàn)

- 25. 5-8 圖像增強api使用

- 26. 5-9 圖像增強實戰(zhàn)

- 27. 5-10 批歸一化實戰(zhàn)(1)

- 28. 5-11 批歸一化實戰(zhàn)(2)

- 30. 6-2 卷積神經(jīng)網(wǎng)絡(luò)的能力

- 29. 6-1 卷積神經(jīng)網(wǎng)絡(luò)的應(yīng)用

- 31. 6-3 圖像風(fēng)格轉(zhuǎn)換V1算法

- 32. 6-4 VGG16預(yù)訓(xùn)練模型格式

- 33. 6-5 VGG16預(yù)訓(xùn)練模型讀取函數(shù)封裝

- 34. 6-6 VGG16模型搭建與載入類的封裝

- 35. 6-7 圖像風(fēng)格轉(zhuǎn)換算法定義輸入與調(diào)用VGG-Net

- 36. 6-8 圖像風(fēng)格轉(zhuǎn)換計算圖構(gòu)建與損失函數(shù)計算

- 37. 6-9 圖像風(fēng)格轉(zhuǎn)換訓(xùn)練流程代碼實現(xiàn)

- 38. 6-10 圖像風(fēng)格轉(zhuǎn)換效果展示

- 39. 6-11 圖像風(fēng)格轉(zhuǎn)換V2算法

- 40. 6-12 圖像風(fēng)格轉(zhuǎn)換V3算法

- 41. 7-1 序列式問題

- 42. 7-2 循環(huán)神經(jīng)網(wǎng)絡(luò)

- 43. 7-3 長短期記憶網(wǎng)絡(luò)

- 44. 7-4 基于LSTM的文本分類模型(TextRNN與HAN)

- 45. 7-5 基于CNN的文本分類模型(TextCNN)

- 46. 7-6 RNN與CNN融合解決文本分類

- 47. 7-7 數(shù)據(jù)預(yù)處理之分詞

- 48. 7-8 數(shù)據(jù)預(yù)處&63972;之詞表生成與類別表生成

- 49. 7-9 實戰(zhàn)代碼模塊解析

- 50. 7-10 超參數(shù)定義

- 51. 7-11 詞表封裝與類別封裝

- 52. 7-12 數(shù)據(jù)集封裝

- 53. 7-13 計算圖輸入定義

- 54. 7-14 計算圖實現(xiàn)

- 55. 7-15 指標(biāo)計算與梯度算子實現(xiàn)

- 56. 7-16 訓(xùn)練流程實現(xiàn)

- 57. 7-17 LSTM單元內(nèi)部結(jié)構(gòu)實現(xiàn)

- 58. 7-18 TextCNN實現(xiàn)

- 59. 7-19 循環(huán)神經(jīng)網(wǎng)絡(luò)總結(jié)

- 60. 8-1 圖像生成文本問題引入&12042;

- 61. 8-2 圖像生成文本評測指標(biāo)

- 62. 8-3 Encoder-Decoder框架與Beam Search算法生成文本

- 63. 8-4 Multi-Modal RNN模型

- 64. 8-5 Show and Tell模型

- 65. 8-6 Show attend and Tell 模型

- 66. 8-7 Bottom-up Top-down Attention模型

- 67. 8-8 圖像生成文本模型對比與總結(jié)

- 69. 8-10 圖像特征抽取(1)-文本描述文件解析

- 70. 8-11 圖像特征抽取(2)-InceptionV3預(yù)訓(xùn)練模型抽取圖像特征

- 71. 8-12 輸入輸出文件與默認參數(shù)定義

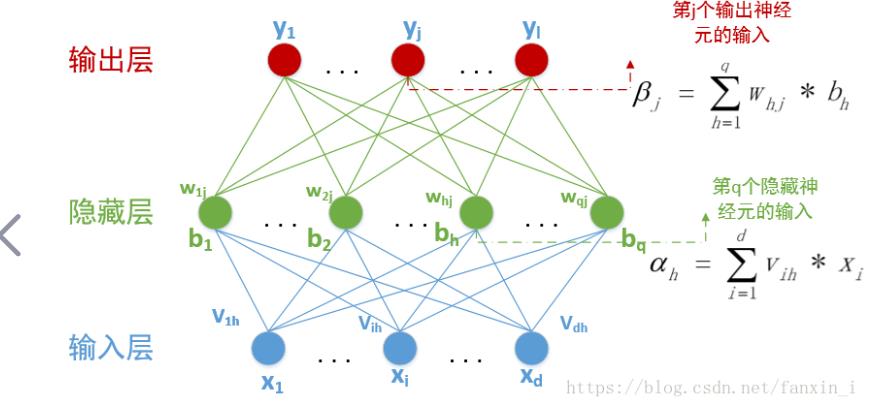

人工神經(jīng)網(wǎng)絡(luò)(Artificial Neural Networks,ANN)系統(tǒng)是 20 世紀(jì) 40 年代后出現(xiàn)的。它是由眾多的神經(jīng)元可調(diào)的連接權(quán)值連接而成,具有大規(guī)模并行處理、分布式信息存儲、良好的自組織自學(xué)習(xí)能力等特點。BP(Back Propagation)算法又稱為誤差 反向傳播算法,是人工神經(jīng)網(wǎng)絡(luò)中的一種監(jiān)督式的學(xué)習(xí)算法。BP 神經(jīng)網(wǎng)絡(luò)算法在理論上可以逼近任意函數(shù),基本的結(jié)構(gòu)由非線性變化單元組成,具有很強的非線性映射能力。而且網(wǎng)絡(luò)的中間層數(shù)、各層的處理單元數(shù)及網(wǎng)絡(luò)的學(xué)習(xí)系數(shù)等參數(shù)可根據(jù)具體情況設(shè)定,靈活性很大,在優(yōu)化、信號處理與模式識別、智能控制、故障診斷等許 多領(lǐng)域都有著廣泛的應(yīng)用前景。

神經(jīng)網(wǎng)絡(luò)算法課程涉及神經(jīng)網(wǎng)絡(luò)的基本概念、結(jié)構(gòu)、工作原理和應(yīng)用。學(xué)習(xí)此課程需要具備一定的數(shù)學(xué)基礎(chǔ),包括線性代數(shù)、微積分和概率論等知識。在課程中,學(xué)生將學(xué)習(xí)神經(jīng)元、激活函數(shù)、前向傳播、反向傳播等基本概念,以及常見的神經(jīng)網(wǎng)絡(luò)結(jié)構(gòu),如多層感知機、卷積神經(jīng)網(wǎng)絡(luò)和循環(huán)神經(jīng)網(wǎng)絡(luò)等。此外,學(xué)生還將學(xué)習(xí)如何使用神經(jīng)網(wǎng)絡(luò)解決分類、回歸、聚類和生成等問題,并學(xué)習(xí)調(diào)參、訓(xùn)練技巧和優(yōu)化算法等實用技能。最終,學(xué)生將能夠獨立設(shè)計和實現(xiàn)神經(jīng)網(wǎng)絡(luò)模型,并應(yīng)用于實際問題中。